Wir bringen Sie ins Internet

Ob Sie ein Verein oder eine kleine Organisation sind, wir bringen Sie ins Internet. Schnell und ohne viel Aufwand. Neben den eigentlichen Inhalten, die Sie im Internet präsentieren möchten, sind vier Schritte notwendig:

1) Wahl des Domainnamens und des Providers

2) Anmelden der Internetseiten bei den Suchmaschinen

3) Internetseiten erreichbar machen

4) Kontinuierliche Betreuung Ihrer Internetpräsenz

Wahl des Domainnamens und des Providers

Bei der Wahl des Domainnamens sollte man sehr sorgfältig sein, umso kürzer und prägnanter der Name, umso besser kann man Ihn sich merken und z. B. am Telefon weitergeben. Wenn möglich wird der Eigenname ausgewählt. Sollte diese Adresse belegt sein, kann man die Abkürzung oder einen Zusatz wie -online wählen, aber auch eine andere Top Level Domain als Endung der Adresse auswählen. Die häufigsten Top Level Domains sind:

.de (Deutschland)

.info (Informationsanbieter)

.eu (Europa)

.int (International)

.net (ursprünglich für Netzverwaltungseinrichtungen, heute frei für jeden)

.com (für kommerzielle Anbieter)

.biz (nur für Unternehmen)

.pro (Professionals, für Freiberufler)

.mobi (für Anbieter die Ihr Angebot für mobile Endgeräte optimiert haben

Dazu kommen alle Länder spezifischen Top Level Domains, wie .nl (Niederlande), fr (Frankreich) oder .cx (Weihnachtsinsel) etc. Seit dem Jahr 2009 wurden weitere Top Level Domains freigeschaltet.

Internet Service Provider (ISP) bieten meistens die Möglichkeit nach seiner Wunschdomain zu suchen und geben noch freie Varianten an, wenn der gewünschte Domainname bereits vergeben ist. Über den Provider kann man aber nicht nur den Domainnamen reservieren lassen, sie stellen auch den Speicherplatz für die Internetseiten, die E-Mail Adressen, Passwortgeschützte Bereiche und andere Dienste zur Verfügung. Wir können die Einrichtung Ihrer Domain bei einem ISP Ihrer Wahl übernehmen und organisieren den Zugangs für Sie.

Anmelden der Internetseiten bei den Suchmaschinen

Die Milliarden von Internetseiten wäre ohne Suchmaschinen nicht mehr zu überblicken. Eine neue Homepage kann bei einigen Suchmaschinen angemeldet werden. Zusätzlich forschen Suchmaschinen nach neuen Internetseiten. Dieses automatische durchsuchen der Seiten und die Speicherung der Daten bei den Suchmaschinen sollte in sinnvolle Bahnen gelenkt werden. So können beispielsweise einzelne Ordner von der Indexierung ausgeschlossen werden. Es können bestimmte Stichworte eingegeben werden, um das Internetangebot thematisch zu ordnen. Die Suchmaschinen zeigen in Ergebnissen meist Seitentitel, Beschreibung und die URL. Je aussagekräftiger diese sind, desto eher stößt das Angebot auf Interesse >> Meta Informationen.

Die Milliarden von Internetseiten wäre ohne Suchmaschinen nicht mehr zu überblicken. Eine neue Homepage kann bei einigen Suchmaschinen angemeldet werden. Zusätzlich forschen Suchmaschinen nach neuen Internetseiten. Dieses automatische durchsuchen der Seiten und die Speicherung der Daten bei den Suchmaschinen sollte in sinnvolle Bahnen gelenkt werden. So können beispielsweise einzelne Ordner von der Indexierung ausgeschlossen werden. Es können bestimmte Stichworte eingegeben werden, um das Internetangebot thematisch zu ordnen. Die Suchmaschinen zeigen in Ergebnissen meist Seitentitel, Beschreibung und die URL. Je aussagekräftiger diese sind, desto eher stößt das Angebot auf Interesse >> Meta Informationen.

Experten gehen davon aus, dass sich die Position eines Internetangebotes in den Google Suchergebnissen aus etwa 200 Parametern ableitet (ct 24/2007, S. 48 ff). Weder ist alles bekannt was dazugehört, noch wie die einzelnen Elemente gewichtet werden. Niemand streitet jedoch ab, dass Links von anderen, inhaltlich ähnlichen Seiten, eine wichtige Rolle spielen. Oft genug bekommt man den Eindruck, dass Inhalte von Internetseiten mehr den Kriterien der Suchmaschinen, denn den Bedürfnissen der Leser und Leserinnen angepasst werden. Kritisch wurde ein in diesem Zusammenhang der im April 2005 ausgerufene Wettbewerb des ![]() Heise-Verlages zur "Hommingberger Gepardenforelle" gesehen. Bei diesem Wettbewerb wurde das Ranking verschiedener Suchmaschinen untersucht, indem Homepages zu dem Phantasiebegriff der "Hommingberger Gepardenforelle" erstellt wurden. Ziel war es nach einem bestimmten Zeitpunkt an erster Stelle bei den Suchmaschinen zu erscheinen

Heise-Verlages zur "Hommingberger Gepardenforelle" gesehen. Bei diesem Wettbewerb wurde das Ranking verschiedener Suchmaschinen untersucht, indem Homepages zu dem Phantasiebegriff der "Hommingberger Gepardenforelle" erstellt wurden. Ziel war es nach einem bestimmten Zeitpunkt an erster Stelle bei den Suchmaschinen zu erscheinen ![]() Weitere Informationen zum Wettbewerb.

Weitere Informationen zum Wettbewerb.

Alles Google oder was...

Etwas im Internet zu suchen, wird nicht nur in Deutschland als "googeln" bezeichnet. Die Umkehrung dieses Gedanken ist für die Anbieter im Internet ein Schreckensbild: Was nicht von Google angezeigt wird, wird auch (fast) nicht wahrgenommen. Der Konzern Google unternimmt große Anstrengungen um SPAM-Seiten (also Seiten, die keine Inhalte, sondern nur Werbung anzeigen) auszuschließen und erntet damit breite Zustimmung. Wer jedoch fälschlicherweise als Spammer ausgeschlossen wird, steht vor dem Zusammenbruch der Besucherzahlen. Google hat mit dem Webmaster Tool einige Möglichkeiten geschaffen die Indexierung zu beeinflussen, aber faktisch bleibt, nach dem Prinzip Hoffnung, nur das Warten auf den nächsten Besuch des Google Bots, die dann hoffentlich die Seiten wieder Indexieren.

Neben Google sind wohl die bekanntesten Suchmaschinen ![]() bing und

bing und ![]() Yahoo, die inzwischen von Microsoft aufgekauft wurde. Eine Besprechung dieser Suchmaschine finden Sie hier. Eine weitere ist

Yahoo, die inzwischen von Microsoft aufgekauft wurde. Eine Besprechung dieser Suchmaschine finden Sie hier. Eine weitere ist ![]() Seekport, wo zusätzlich zu den Suchbegriffen Bilder und Produkte eingeblendet werden können. Die nach eigenen Angaben diskreteste Suchmaschine ist

Seekport, wo zusätzlich zu den Suchbegriffen Bilder und Produkte eingeblendet werden können. Die nach eigenen Angaben diskreteste Suchmaschine ist ![]() ixquick. Ixquick speichert keine IP-Adressen und gibt auch keine persönlichen Daten an Dritte weiter. Ixquick bemüht sich um den bestmöglichen Schutz der Privatsphäre seiner Nutzer. Die Suchmaschine

ixquick. Ixquick speichert keine IP-Adressen und gibt auch keine persönlichen Daten an Dritte weiter. Ixquick bemüht sich um den bestmöglichen Schutz der Privatsphäre seiner Nutzer. Die Suchmaschine ![]() DuckDuckGo erlaubt ebenfalls das anonyme Durchsuchen des Internets. Weder werden personenbezogene Daten gesammelt oder ausgewertet, noch wird die Suche verfolgt, was später erlaubt, dass personenbezogene Werbung von Drittanbietern eingeblendet und ein Profil erstellt werden kann.

DuckDuckGo erlaubt ebenfalls das anonyme Durchsuchen des Internets. Weder werden personenbezogene Daten gesammelt oder ausgewertet, noch wird die Suche verfolgt, was später erlaubt, dass personenbezogene Werbung von Drittanbietern eingeblendet und ein Profil erstellt werden kann.

Einige deutschsprachige Suchmaschinen

![]() http://www.exalead.com/search/

http://www.exalead.com/search/

Meta Informationen

Hier handelt es sich um Informationen, die im Kopf <head> einer Seite, für den Besucher unsichtbar, eingebaut werden. Diese Angaben dienen den Servern, Web-Browsern und den Suchmaschinen Robotern (robots). Hier können Angaben zu den Autoren einer Seite, Stichworte und eine allgemeine Beschreibung der Seite etc. gegeben werden. ![]() weitere Informationen zu Meta Informationen.

weitere Informationen zu Meta Informationen.

Parameter

| Angaben zum Autor | <meta name="author" content="ihr Name"> |

| Stichworte | <meta name="keywords" lang="de" content="die Stichworte werden durch Komma getrennt"> Sie können hier Stichworte für die Suchmaschinen bestimmen. |

| Stichworte (englisch) |

Mit dem Parameter "lang=" wird die Sprache festgelegt. lang="en" Stichworte in englischer Sprache. fr = französisch it = italienisch es = spanisch |

| Datum | <meta name="date" content="2018-01-15"> |

| Durchsuchen der Dateien einer Homepage durch Suchmaschinen erlauben/verbieten |

<meta name="robots" content="follow"> Erlaubt Suchmaschinen das Durchsuchen der gesamten Homepage. <meta name="robots" content="nofollow"> Erlaubt das Durchsuchen der aktuellen Seite aber nicht der folgenden. <meta name="robots" content="index"> Erlaubt das Durchsuchen der Indexseite <meta name="robots" content="noindex"> verbietet das Durchsuchen der Dateien = keine Indexierung Einzelne Ordner und Dateinen können in einer speziellen Datei "robots.txt" von der Suche ausgeschlossen werden. |

| Beschreibung | <meta name="description" content="Beschreibung Ihrer Seite"> Diese Beschreibung wird beim Suchergebnis mit angezeigt. Sie sollte möglichst kurz sein. >> Beispiel |

| Laden der Originaldateien |

Dateien werden, um die Ladenzeiten einer Seite zu erhöhen, Zwischengespeichert. Dies gescheit bei sogenannten Proxyserver, wie auch lokal auf dem Rechner. Erneuern sich die Inhalte einer Seite häufiger ist es sinnvoll die Orginalseiten in regelmäßigen Abständen zu laden. <meta http-equiv="expires" content="0"> es werden immer die Orginaldateien geladen. Statt 0 können Sie auch eine Zahl eingeben. Diese Zahl bedeutet dann die Anzahl der Sekunden, nach deren Ablauf die Orginaldaten geladen werden. <meta http-equiv="expires" content="86400"> Bei diesem Beispiel wird der Inhalt alle 24 h erneuert. |

| Kompatibilität | Neu ist die Meta Angabe der Browser Kompatibilität. Sie soll die DOCTYPE Angaben, bzw. die Angaben auf den Seiten "Optimiert für..." ablösen. Mit dem Meta-Tag <meta http-equiv="X-UA-Compatible" content="IE=8" /> soll der Browser dazu gebracht werden die Seiten nach dem beschriebenen Standard darzustellen. |

Internetseiten erreichbar machen

|

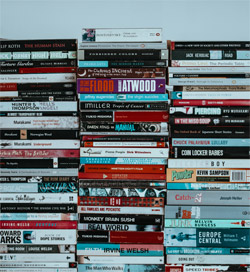

| Foto von Annie Spratt auf Unsplash |

Die Menschheit soll erfahren, was uns wichtig ist. Das ist der Grund um Material zu publizieren, es zu veröffentlichen. Jahr für Jahr erscheinen viele zehntausend deutschsprachige Bücher. Kein Mensch kann diese Masse überblicken und die meisten von uns sind nicht unglücklich, nur von einem kleinen Teil Kenntnis zu erhalten.

Im Jahr 2016 waren mehr als 14.000.000 Internetadressen mit der Endung ".de" registriert (1). Auch hier sprengt die Menge das Vorstellungsvermögen. Ein großer Vorteil des digitalen Publizierens ist gleichzeitig ein Nachteil: Es ist so einfach, eine Adresse anzumelden und Material hoch zu laden, um es der Öffentlichkeit in aller Welt zugänglich zu machen.

Nicht alles ist für den Einzelnen interessant. Bei der Auswahl kann eine Analogie aus der Welt der Bücher helfen: Ein paar zusammengeklammerte Blätter werden anders eingeschätzt als ein Taschenbuch mit schön gestaltetem Umschlag oder ein goldverzierter Ledereinband. Den Inhalten wird, abhängig von der Art der Präsentation, eine unterschiedliche Bedeutung zugemessen.

Aber Schreibfehler, schiefe Seiten, falsche Seitenzahlen in einem Buch oder Rechtschreibfehler, tote Links, Elemente, die sich überlagern bei der Internetpräsenz, das geht gar nicht. Wer bei der Veröffentlichung schlampig ist und der Leserschaft keinen Respekt zollt, hat sich den respektvollen Umgang mit dem publizierten Material nicht verdient. Damit fallen die ein oder anderen Millionen Internetadressen aus dem Raster.

Der Rest ist aber immer noch groß genug, dass es Werkzeuge braucht, um Antworten auf die eigenen Fragen zu finden. Es gibt Vereine, die eine Internetseite nur für die interne Kommunikation benötigen, andere möchten nur einer ausgewählten Gruppe die Informationen zur Verfügung stellen. In diesen Fällen reicht es, die URL weiterzugeben. Soll Material von einer breiteren Öffentlichkeit gefunden werden, die nicht direkt die Internetadresse (URL) eintippen, werden Suchmaschinen benötigt. Wie in jedem guten Katalog muss man sich vorher Gedanken machen, wie Internetangebote die Ergebnisseiten der Suchmaschinen erreichen können und sollen.

Als erstes: Eine Internetadresse, die in der URL das Thema enthält, um dass es geht, können sich Interessierte leicht merken - und es wird in der Regel von den Suchmaschinen mit besserer Platzierung belohnt.

Links

Ziel der Suchmaschinenbetreiber ist es, der Kundschaft schnell zu den gesuchten Informationen zu verhelfen - sie wollen nützlich sein. Nur dann kommen viele Menschen immer wieder und klicken auch auf die Anzeigen im Umfeld der Suchergebnisse (und das bringt das Geld). Woran sind nützliche Internetseiten zu erkennen, die es verdient haben ganz oben in der Liste der Suchergebnisse zu stehen? Bei dieser Entscheidung hilft, die Benutzer zu beobachten: Suchergebnisse, die oft angeklickt werden, rutschen nach oben. Internetseiten, auf die von vielen anderen Seiten verlinkt wird, werden ebenfalls besser bewertet. Es kann also sinnvoll sein andere Betreiber darum zu bitten, Links zu setzen. Doch Vorsicht: Einige Menschen waren überschlau und haben Seiten mit Links und Backlinks automatisch in großer Zahl hoch geladen. Übertreibung führt zur Abwertung und ![]() "Linkfarms" werden inzwischen ganz aus den Suchergebnissen entfernt. Zu beachten ist zusätzlich, dass Links von Seiten kommen sollten, die thematisch verwandt sind. Auch Links aus

"Linkfarms" werden inzwischen ganz aus den Suchergebnissen entfernt. Zu beachten ist zusätzlich, dass Links von Seiten kommen sollten, die thematisch verwandt sind. Auch Links aus ![]() Social-Bookmarking Diensten, wie MisterWong oder LinkArena helfen bei der besseren Platzierung. Ebenso können bei Facebook, Google+, Twitter oder anderen Social Media Plattformen wie Xing und Linked in Links gesetzt werden.

Social-Bookmarking Diensten, wie MisterWong oder LinkArena helfen bei der besseren Platzierung. Ebenso können bei Facebook, Google+, Twitter oder anderen Social Media Plattformen wie Xing und Linked in Links gesetzt werden.

Es ist vorteilhaft "permanente Links" zu verwenden, die exakt so auch nach Monaten und Jahren erreichbar sind. Nach wenigen Wochen sind die meisten veröffentlichten Dateien von den Suchmaschinen gefunden und in Datenbanken gespeichert. Werden Dateinamen oder -pfade verändert, führen die gespeicherten Links der Suchmaschinen ins Leere - das wirkt sich schlecht auf die Platzierung aus. Für andere Autoren haben häufige Umgestaltungen den Nachteil, das Links immer wieder angepasst werden müssen. Neue Dateien hinzuzufügen ist hingegen kein Problem.

Stichworte eingeben

Aus der Welt der Bibliotheken sind Stichwortkataloge bekannt. Bei Internetseiten gibt es die Möglichkeit, selbst Stichworte in die Meta-Tags im Header der HTML-Datei zu schreiben. Dabei kann es sinnvoll sein zu überlegen, welche Stichworte für Suchende interessant sein könnten. Die Stichworte sollten für jede einzelne Seite angepasst werden. Dabei gilt es zu bedenken, das die Experten manchmal andere Worte kennen und nutzen, als gewöhnliche Menschen.

Inhalte zusammenfassen

Die in den Meta-Tags gespeicherte Inhaltsangabe (meta name="description" oder name="abstract") wird von vielen Suchmaschinen in den Trefferlisten angezeigt. Es lohnt sich hier den Inhalt der Seite kurz zusammenzufassen, denn das gibt dem Benutzer die Möglichkeit den Inhalt schnell einzuschätzen und zu entscheiden, ob der Treffer interessant ist. Für die Zusammenfassung sollten maximal 170 Zeichen verwendet werden, weil das die Textmenge ist, die beispielsweise bei den Google Suchergebnissen angezeigt wird.

Welche Techniken sollten verwendet werden?

Es gibt Techniken, die es den Suchmaschinen schwer machen mit Ihren Webcrawlern die Inhalte zu durchsuchen und den eigenen Datenbanken hinzuzufügen. ![]() Content Management Systeme (CMS) haben viele Vorteile: die Inhalte sind in einer Datenbank abgespeichert und können, je nach belieben und Endgerät unterschiedlich präsentiert werden. CMS machen es auch sehr einfach, interne Links zu verwalten oder einen RSS-Feed zu veröffentlichen. Sie haben allerdings oft den Nachteil, dass die Datenbank von Suchmaschinen nicht durchsuchbar ist und keine "permanenten Links" zur Verfügung gestellt werden. Dass es auch anders geht, zeigt die Wikipedia.

Content Management Systeme (CMS) haben viele Vorteile: die Inhalte sind in einer Datenbank abgespeichert und können, je nach belieben und Endgerät unterschiedlich präsentiert werden. CMS machen es auch sehr einfach, interne Links zu verwalten oder einen RSS-Feed zu veröffentlichen. Sie haben allerdings oft den Nachteil, dass die Datenbank von Suchmaschinen nicht durchsuchbar ist und keine "permanenten Links" zur Verfügung gestellt werden. Dass es auch anders geht, zeigt die Wikipedia.

Die Verwendung von Frames ist, nicht nur aus diesen Gründen, nicht zu empfehlen. iFrames funktionieren besser. Da der Flash-Player zunehmend verschwindet, sollte auf Animationen oder Navigationen mit Flash verzichtet werden. Sitzungs-IDs, oder Hashes, die oft an die URL angehängt werden, um das Verhalten der Lesenden zu beobachten, erschweren den Crawlern ebenso die Orientierung. PHP funktioniert grundsätzlich anders und präsentiert nicht nur der Kundschaft, sondern auch den Webcrawlern die komplette Seite.

Wie werden Suchergebnisse gewichtet

Nun beginnt der Bereich, wo sich die Suchmaschinen in Schweigen hüllen: Um Manipulationen der Suchergebnisse zu erschweren, werden die Details zu Gewichtung und zur Bedeutung weiterer Faktoren verschwiegen. Es gibt Hinweise, dass Internetangebote, die immer wieder aktualisiert werden, eine höhere Bewertung bekommen. Zwar ignorieren viele Benutzer die Titelzeile des Browserfensters, aber die Suchmaschinen beachten sie höchstwahrscheinlich.

Es ist sinnvoll, sich bei der Gestaltung der Seiten an die aktuellen W3C-Vorgaben zu halten. Zum Beispiel sollten im Hauptfenster für Überschriften die Standard-Tags, wie Überschrift erster Ordnung <h1> und Überschrift zweiter Ordnung <h2> verwendet werden. Die Webcrawler der Suchmaschinen sind höchstwahrscheinlich entsprechend strukturiert. Die positive Wirkung sinnvoller Backlinks, wurde bereits oben im Text angesprochen. Klasse sei, wenn jemand eine "Rezension" über die Internetseiten schreibt und hochlädt. Wenn wenige Klicks genügen, um die Inhalte der Seite zu finden, soll das genauso helfen, wie die sinnvolle Verwendung "interner Links", also der Verweis auf verwandte Inhalte in der eigenen Internetpräsenz. "Sprechende Dateinamen" aus denen sich der Inhalt der Datei erraten lässt, helfen nicht nur dem Webadministrator, sondern auch den Suchmaschinen. Nicht nur Google wertet eine Standard-konforme sitemap.xml aus.

Eine öde Arbeit ist es Grafiken mit Alternativtexten und Links mit Titeln zu versehen. Auch das werde von Suchmaschinen goutiert … Menschen die Screenreader (>> Barrierefreiheit) verwenden müssen, hilft es auch. Die Ressourcen der Suchmaschinen seien begrenzt, wird spekuliert. Ob also die 100ste Codezeile noch ausgewertet werde, sei weniger unsicher als bei der 300sten oder der 1000sten Zeile.

Hartnäckig halten sich Gerüchte, dass Internetadressen, die mit den "Adwords" (kostenpflichtige Google Anzeigen) beworben werden, bei Google besser abschneiden.

Es gibt Firmen, die "Search Engine Optimizing" (SEO) kostenpflichtig anbieten. Es ist fraglich, ob und wie viel das bringen kann. Garantien gibt es keine, aber es beseht die Gefahr bei einem weniger seriösen Anbieter zu landen und als Teil einer Linkfarm aus den Suchergebnissen zu fliegen.

Diese Hinweise sind inzwischen weit verbreitet und werden von sehr vielen Webadmins beachtet. Der Rückschluss ist zulässig: wer das ignoriert hat schlechte Aussichten Besuche zu bekommen, die nach den Inhalten und nicht direkt nach dem Anbieter suchen.

Die Suchmaschinen sind ständigen Versuchen ausgesetzt, die Reihenfolge der Suchergebnisse (Ranking) zu manipulieren. Deshalb gibt es keine vollständigen und verbindlichen Aussagen dazu, wie die Suchergebnisse sortiert werden. Die Regeln zur Platzierung werden auch laufend geändert und ergänzt. Die Bedeutung einzelner Elemente lässt sich nicht seriös abschätzen.

Wer diese Hinweise bei der Gestaltung der Internetseiten beachtet, verbessert nicht nur die Aussichten bei den Suchmaschinen; vieles hat auch die angenehme Nebenwirkung, dass die Menschen besser mit den Seiten zurechtkommen.

Aber das Nonplusultra ist und bleibt der Inhalt: Vernünftig schreiben und präsentieren und die Leserschaft immer im Blick haben.

Weitere Themen

>> Überlegungen zur Nutzung von Google Analytics auf kleinen Websites

>> Statistik

Quellen

(1) ![]() https://www.denic.de/

https://www.denic.de/

Artikel in der ![]() Zeitschrift c‘t:

Zeitschrift c‘t:

c't 2005 Heft 9, S. 158-166

c't 2005 Heft 12, S. 38-40

c't 2006 Heft 1, S. 76-78

Kontinuierliche Betreuung Ihrer Internetpräsenz

Um im Internet Aufmerksamkeit zu bekommen sind aktuelle Inhalte wichtig. Gerade deshalb bieten wir Ihnen Pauschalen. So haben Sie die finanzielle Sicherheit und bekommen für ein Jahr nicht nur die technische Betreuung, sondern auch Aktuelles und ergänzende Informationen zeitnah veröffentlicht. Soll etwas schneller gehen dann reicht ein Anruf. Ebenfalls können Sie innerhalb dieses Jahres auch leicht ihr Angebot erweitern, denn oft kommen mit der Zeit und den Rückmeldungen der Besucher neue Ideen. Darüberhinaus verändern sich die technischen Anforderungen an eine Internetseite. Vor einigen Jahren haben nur wenige Menschen über die Barrierefreiheit einer Internetseite nachgedacht, heute ist es für viele Seite Voraussetzung. Schrift wurden früher direkt im Text formatiert, heute kann man sie bequem in einer zentralen Datei speichern. Nach einigen Jahren entsteht oft der Wunsch das Layout oder die Navigation der Seiten zu überarbeiten. Auch die Nutzungsgewohnheiten im Internet wandeln sich beständig. Aus diesen Gründen sollte eine Homepage von Zeit zu Zeit an aktuelle Standards angepasst werden.

Wir schreiben bewusst keine Preise für unsere Angebote auf, denn jedes Projekt stellt andere Anforderungen, wenn Sie Ihre Wünsche kurz vorstellen geben wir gerne über die Kosten Auskunft.

Allgemeine Geschäftsbedingungen ![]()

Letzte Aktualisierung: Mittwoch 17.07.2024